En lugar de entrar en matemáticas, intentaré explicarlo en palabras sencillas. Si tienes toda la población a tu disposición, entonces su varianza (varianza de la población) se calcula con el denominador N. Del mismo modo, si solo tienes una muestra y quieres calcular la varianza de la muestra, utilizas el denominador N (n de la muestra, en este caso). En ambos casos, ten en cuenta que no estás estimando nada: la media que mediste es la verdadera media y la varianza que calculaste a partir de esa media es la verdadera varianza.

Ahora, tienes solo una muestra y quieres inferir sobre la media y varianza desconocidas en la población. En otras palabras, quieres estimar. Toma tu media de la muestra como estimación de la media de la población (porque tu muestra es representativa), vale. Para obtener la estimación de la varianza de la población, tienes que fingir que esa media es realmente la media de la población y por lo tanto ya no depende de tu muestra desde que la calculaste. Para "demostrar" que ahora la consideras fija, reservas una (cualquiera) observación de tu muestra para "respaldar" el valor de la media: pase lo que pase en tu muestra, una observación reservada siempre podría llevar la media al valor que obtuviste y en el que crees que es insensible a las contingencias de muestreo. Una observación reservada es "-1" y por lo tanto tienes N-1 al calcular la estimación de la varianza. La estimación no sesgada se llama varianza de la muestra (que no debe confundirse con la varianza de la muestra) que es un argot; es mejor llamarla como es: estimación no sesgada de la varianza de la población estimada con la media de la muestra.

[Pegando aquí de mis comentarios anteriores: Imagina que tomas muestras repetidamente de tamaño N=3. De los 3 valores en una muestra, solo 2 valores expresan la desviación aleatoria de las observaciones de la media de la población, pero el restante expresa (asume) el desplazamiento de la media de la muestra de la media de la población. Por lo tanto, el "grado de libertad" de la variabilidad observacional es de 2 de los 3, en cada muestra independiente. Cuando estimamos la variabilidad en una muestra pero queremos que sea una estimación imparcial (sin desplazamientos) de la variabilidad poblacional, "creemos" solo en esas 2 observaciones libres. "Pagamos" por la decisión de medir la variabilidad a partir de la media de la muestra como si fuera la media de la población, porque necesitamos inferir sobre la variabilidad poblacional. Esta "tarifa" (denominador N-1, la corrección de Bessel) hace que la variabilidad sea más amplia, incorporando la oscilación de las medias de las muestras dentro de la varianza, pero hace que dicha varianza sea un estimador imparcial.]

Pero imagina ahora que de alguna manera conoces la verdadera media de la población, pero quieres estimar la varianza a partir de la muestra. Entonces sustituirás esa verdadera media en la fórmula de la varianza y aplicarás el denominador N: no se necesita "-1" aquí ya que sabes la verdadera media, no la estimaste a partir de esta misma muestra.

6 votos

Puedes encontrar una respuesta aquí: stats.stackexchange.com/questions/16008/…. Básicamente, deberías usar N-1 cuando estimas una varianza, y N cuando la calculas exactamente.

0 votos

@ocram, hasta donde yo sé, cuando estimamos una varianza usamos ya sea n o n-1.

0 votos

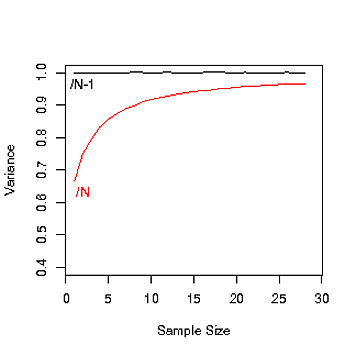

Si deseas que tu estimador sea imparcial, entonces debes usar n-1. Ten en cuenta que cuando n es grande, esto no es importante.

2 votos

Ninguna de las respuestas a continuación está escrita en términos de inferencia de población finita. La palabra finite es absolutamente crucial aquí; de eso trata el libro de Kish (y quienquiera que haya dicho "El libro está equivocado" simplemente no sabe lo suficiente sobre encuestas y muestras de poblaciones finitas). El cociente $N-1$ en lugar de $N$ simplemente hace que los cálculos sean más agradables y obvia la necesidad de llevar factores como $1-1/N$. La respuesta completa a esta pregunta tendría que introducir la inferencia de muestreo donde los indicadores de muestra son aleatorios, y los valores de las características observadas $y$ están FIJOS. No aleatorios. Fijos en piedra.

0 votos

Podrías tener una mejor sensación sobre esta pregunta al jugar con octave or matlab... Ejemplo: x = rand(10,1); var1 = sum((x - mean(x)).^2) / (length(x)); var2 = sum((x - mean(x)).^2) / (length(x)-1); podrás verificar una diferencia significativa entre

var1yvar2, dado que el tamaño de tu muestra es muy pequeño. Repítelo considerando un tamaño de población más grande. x = rand(1e6,1); var1 = sum((x - mean(x)).^2) / (length(x)); var2 = sum((x - mean(x)).^2) / (length(x)-1); verificarás quevar1≈var22 votos

Esto realmente no añade a las otras respuestas. Que diferentes divisores den respuestas diferentes, o incluso que la diferencia disminuya con N, no es el problema. La pregunta es cuándo y por qué usar cualquiera de los dos divisores.

0 votos

Mira este video, responde precisamente a tu pregunta. youtube.com/watch?v=xslIhnquFoE

0 votos

@SahilChaudhary, tu video habla sobre n y n-1. Mi pregunta no tiene nada que ver con n y n-1. Mi pregunta es sobre N y N-1. ¿Puedes ver que n y N son diferentes, verdad? ¡He comentado en mi pregunta!

0 votos

¿Puedes decirnos, de qué libro se trata? @StasK

0 votos

El libro es "Muestreo de encuestas" de "Leslie Kish" de "John Willey & Sons" archive.org/details/in.ernet.dli.2015.214343

1 votos

Me gustaría mencionar a los otros lectores que este problema se denomina "corrección de Bessel". Puedes consultarlo en Wikipedia es.wikipedia.org/wiki/...