Me gusta la respuesta analítica dada por Glen_b. Es una buena respuesta.

Necesita una imagen. Me gustan las imágenes.

Aquí hay áreas de elasticidad en una respuesta a la pregunta:

- Hay muchas distribuciones en el mundo. La eficiencia es probable que varíe.

- Suficiente tiene diferentes significados. Para un contraejemplo de una teoría, a veces se requiere un solo contraejemplo para que se cumpla "suficiente". Para demostrar tasas de defectos bajas utilizando incertidumbre binomial, pueden ser necesarios cientos o miles de muestras.

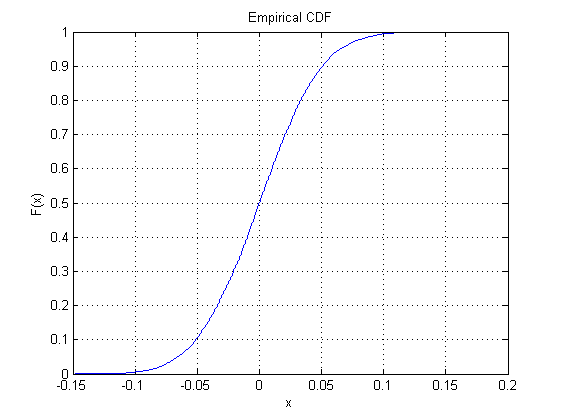

Para una normal estándar utilicé el siguiente código de MatLab:

mysamples=1000;

loops=10000;

y1=median(normrnd(0,1,mysamples,loops));

cdfplot(y1)

y obtuve el siguiente gráfico como resultado:

![introduce la descripción de la imagen aquí]()

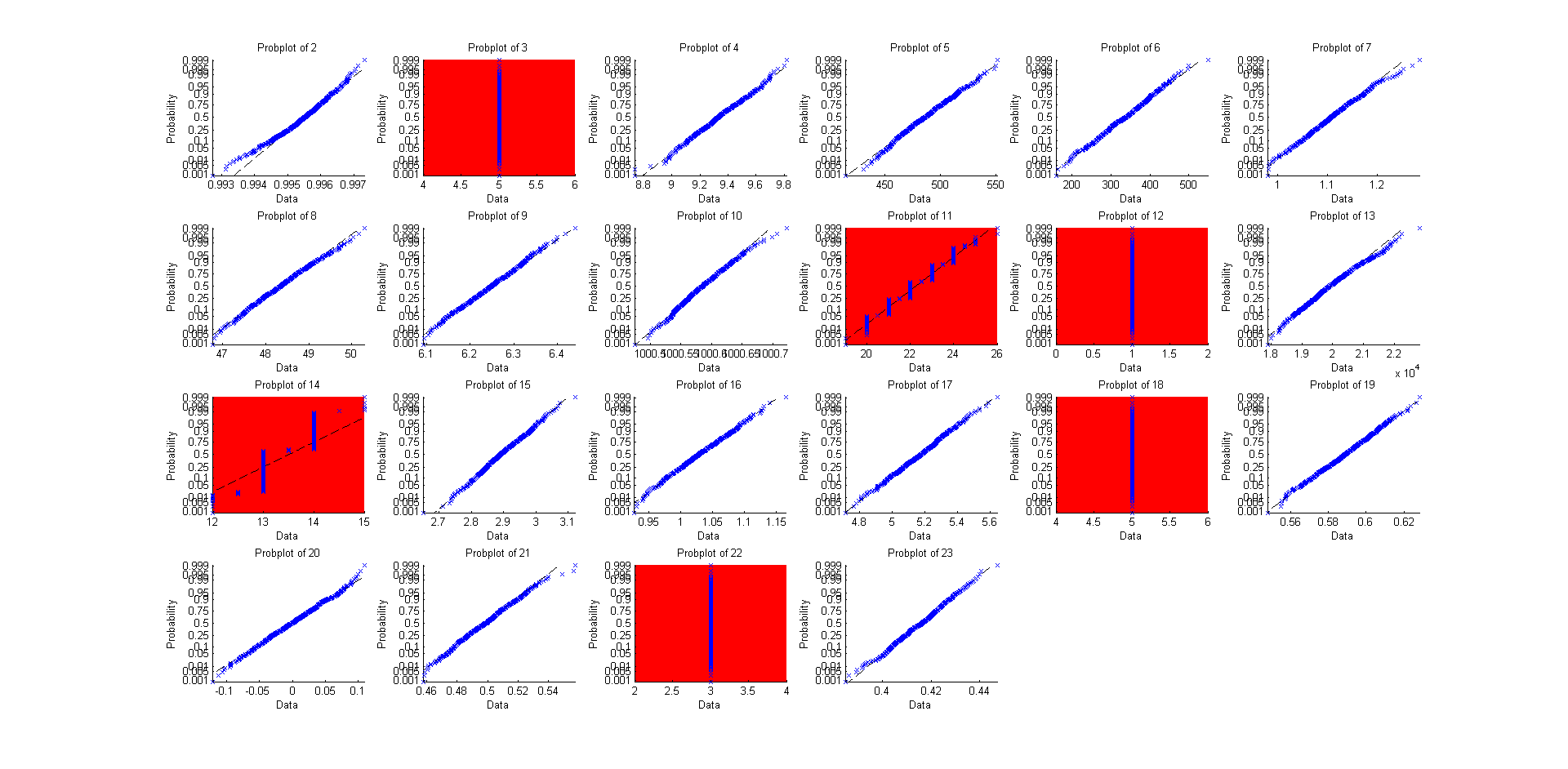

Así que, ¿por qué no hacer esto para las otras 22 o así "distribuciones integradas", excepto usando gráficos de probabilidad (donde una línea recta significa muy similar a una distribución normal)?

![introduce la descripción de la imagen aquí]()

Y aquí está el código fuente para ello:

mysamples=1000;

loops=600;

y=zeros(loops,23);

y(:,1)=median(random('Normal', 0,1,mysamples,loops));

y(:,2)=median(random('beta', 5,0.2,mysamples,loops));

y(:,3)=median(random('bino', 10,0.5,mysamples,loops));

y(:,4)=median(random('chi2', 10,mysamples,loops));

y(:,5)=median(random('exp', 700,mysamples,loops));

y(:,6)=median(random('ev', 700,mysamples,loops));

y(:,7)=median(random('f', 5,3,mysamples,loops));

y(:,8)=median(random('gam', 10,5,mysamples,loops));

y(:,9)=median(random('gev', 0.24, 1.17, 5.8,mysamples,loops));

y(:,10)=median(random('gp', 0.12, 0.81,mysamples,loops));

y(:,11)=median(random('geo', 0.03,mysamples,loops));

y(:,12)=median(random('hyge', 1000,50,20,mysamples,loops));

y(:,13)=median(random('logn', log(20000),1.0,mysamples,loops));

y(:,14)=median(random('nbin', 2,0.11,mysamples,loops));

y(:,15)=median(random('ncf', 5,20,10,mysamples,loops));

y(:,16)=median(random('nct', 10,1,mysamples,loops));

y(:,17)=median(random('ncx2', 4,2,mysamples,loops));

y(:,18)=median(random('poiss', 5,mysamples,loops));

y(:,19)=median(random('rayl', 0.5,mysamples,loops));

y(:,20)=median(random('t', 5,mysamples,loops));

y(:,21)=median(random('unif',0,1,mysamples,loops));

y(:,22)=median(random('unid', 5,mysamples,loops));

y(:,23)=median(random('wbl', 0.5,2,mysamples,loops));

figure(1); clf

hold on

for i=2:23

subplot(4,6,i-1)

probplot(y(:,i))

title(['Gráfico de probabilidad de ' num2str(i)])

axis tight

if not(isempty(find(i==[3,11,12,14,18,22])))

set(gca,'Color','r')

end

end

Cuando veo la prueba analítica, podría pensar "en teoría todos podrían encajar", pero cuando lo pruebo, entonces puedo moderar eso con "hay varias formas en las que esto no funciona tan bien, a menudo involucrando valores discretos o altamente restringidos" y esto podría hacerme querer ser más cuidadoso al aplicar la teoría a cualquier cosa que cueste dinero.

Buena suerte.

10 votos

Necesitas algunas condiciones de regularidad para que la mediana tenga una distribución normal bajo reescalamiento en el límite. Para ver qué puede salir mal, considera cualquier distribución sobre un número finito de puntos, digamos, $X$ uniforme en $\{-1,0,1\}$.

7 votos

En cuanto a las condiciones de regularidad: Si la distribución subyacente tiene una densidad que es diferenciable en la mediana (verdadera), entonces la mediana de la muestra tendrá una distribución normal asintótica con una varianza que depende de dicha derivada. Esto se cumple de forma más general para cuantiles arbitrarios.

7 votos

@cardinal Creo que necesitas condiciones adicionales: cuando la densidad sea dos veces diferenciable, sea igual a cero en la mediana y tenga derivada primera cero en ese punto, entonces la distribución asintótica de la mediana de la muestra será bimodal.

4 votos

@whuber: Sí, porque la densidad (no su derivada como mencioné inadvertidamente antes) entra en la varianza como un recíproco, el valor de la densidad en ese punto no debe ser cero. ¡Disculpas por omitir esa condición!

5 votos

Los contraejemplos elementales se pueden crear utilizando cualquier distribución que asigne una probabilidad de $1/2$ a un intervalo $(-\infty,\mu]$ y probabilidad $1/2$ a $[\mu+\delta,\infty)$ donde $\delta\gt 0,$ como una Bernoulli$(1/2)$ ($\mu=0,\delta=1$). Las medianas de muestra serán menores o iguales a $\mu$ tan a menudo como sean mayores o iguales a $\mu+\delta$. La probabilidad de que la mediana no esté en $(\mu,\mu+\delta)$ tiende a $0$ para muestras grandes, dejando efectivamente un "hueco" en $(\mu,\mu+\delta)$ en la distribución límite, la cual obviamente no será normal, sin importar cómo se estandarice.

1 votos

Ejemplo para mediana de muestra Cauchy.

0 votos

¿Es la mediana de la muestra un estimador imparcial de la mediana de la población? "Claramente sí para las distribuciones normales, pero no está claro si es cierto para otras; especialmente para aquellas no simétricas.