Creo que la confusión puede estar surgiendo de algo un poco más simple, pero brinda una buena oportunidad para revisar algunos temas relacionados.

Nótese que el texto no afirma que todos los coeficientes de regresión $\newcommand{\bhat}{\hat{\beta}}\newcommand{\m}{\mathbf}\newcommand{\z}{\m{z}}\bhat_i$ se pueden calcular a través de los vectores de residuos sucesivos como $$ \bhat_i \stackrel{?}{=} \frac{\langle \m y, \z_i \rangle}{\|\z_i\|^2}\>, $$ sino que solo el último, $\bhat_p$, ¡se puede calcular de esta manera!

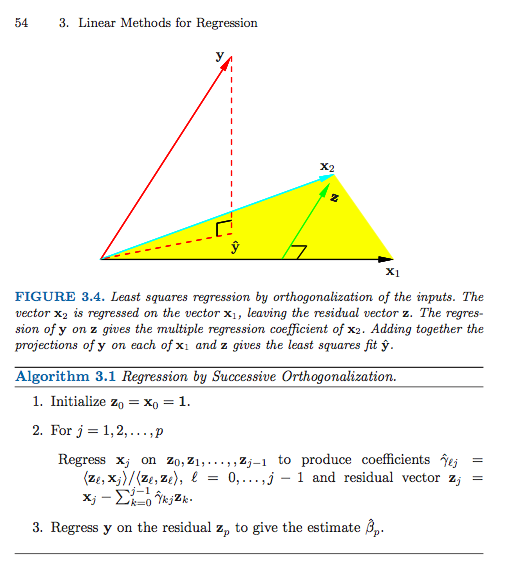

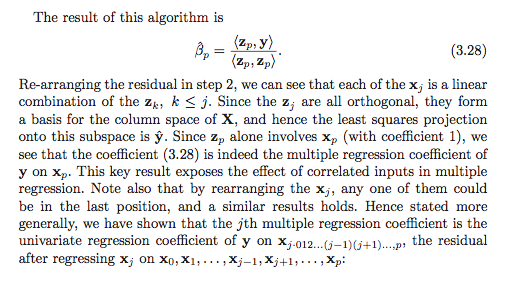

El esquema sucesivo de ortogonalización (una forma de ortogonalización de Gram—Schmidt) está (casi) produciendo un par de matrices $\newcommand{\Z}{\m{Z}}\newcommand{\G}{\m{G}}\Z$ y $\G$ tales que $$ \m X = \Z \G \>, $$ donde $\Z$ es de tamaño $n \times p$ con columnas ortonormales y $\G = (g_{ij})$ es triangular superior de tamaño $p \times p$. Digo "casi" porque el algoritmo solo especifica $\Z$ hasta las normas de las columnas, que en general no serán uno, pero se pueden hacer tener norma unitaria normalizando las columnas y realizando un ajuste simple correspondiente a la matriz de coordenadas $\G$.

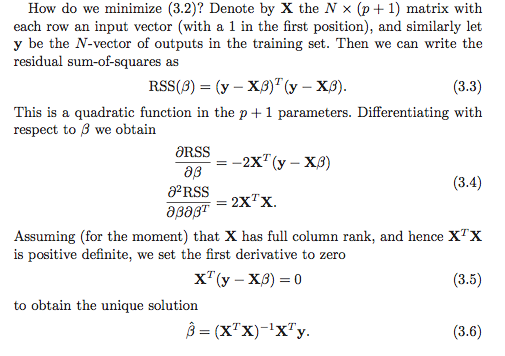

Suponiendo, por supuesto, que $\m X \in \mathbb R^{n \times p}$ tiene rango $p \leq n$, la solución única de mínimos cuadrados es el vector $\bhat$ que resuelve el sistema $$ \m X^T \m X \bhat = \m X^T \m y \>. $$

Sustituyendo $\m X = \Z \G$ y usando $\Z^T \Z = \m I$ (por construcción), obtenemos $$ \G^T \G \bhat = \G^T \Z^T \m y \> , $$ que es equivalente a $$ \G \bhat = \Z^T \m y \>. $$

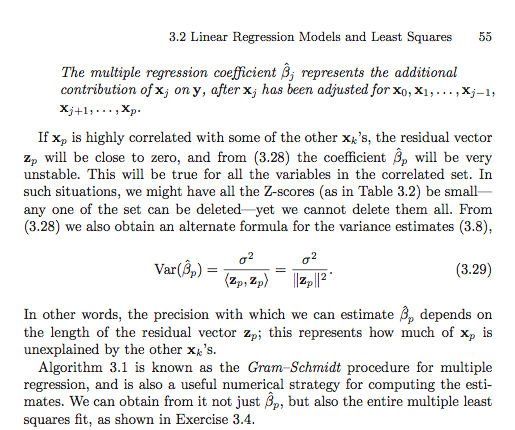

Ahora, concéntrate en la fila última del sistema lineal. El único elemento distinto de cero de $\G$ en la última fila es $g_{pp}$. Entonces, obtenemos que $$ g_{pp} \bhat_p = \langle \m y, \z_p \rangle \>. $$ No es difícil ver (¡verificar esto como una comprobación de entendimiento!) que $g_{pp} = \|\z_p\|$ y así se obtiene la solución. (Caveat lector: He utilizado $\z_i$ ya normalizado a una norma unitaria, mientras que en el libro no lo han hecho. Esto explica el hecho de que en el libro haya una norma al cuadrado en el denominador, mientras que yo solo tengo la norma).

Para encontrar todos los coeficientes de regresión, es necesario hacer un paso de sustitución inversa simple para resolver los individuales $\bhat_i$. Por ejemplo, para la fila $(p-1)$, $$ g_{p-1,p-1} \bhat_{p-1} + g_{p-1,p} \bhat_p = \langle \m z_{p-1}, \m y \rangle \>, $$ y así $$ \bhat_{p-1} = g_{p-1,p-1}^{-1} \langle \m z_{p-1}, \m y \rangle \> - g_{p-1,p-1}^{-1} g_{p-1,p} \bhat_p . $$ Uno puede continuar este procedimiento trabajando "hacia atrás" desde la última fila del sistema hasta la primera, restando sumas ponderadas de los coeficientes de regresión ya calculados y luego dividiendo por el término principal $g_{ii}$ para obtener $\bhat_i.

El punto en la sección en ESL es que podríamos reordenar las columnas de $\m X$ para obtener una nueva matriz $\m X^{(r)}$ con la columna original $r$ ahora siendo la última. Si luego aplicamos el procedimiento de Gram–Schmidt a la nueva matriz, obtenemos una nueva ortogonalización de manera que la solución para el coeficiente original $\bhat_r$ se encuentra mediante la solución simple anterior. Esto nos da una interpretación para el coeficiente de regresión $\bhat_r$. Es una regresión univariante de $\m y$ en el vector residual obtenido por "regresar" las columnas restantes de la matriz de diseño de $\m x_r$.

Descomposiciones QR generales

El procedimiento de Gram–Schmidt es solo un método de producir una descomposición QR de $\m X$. De hecho, existen muchas razones para preferir otros enfoques algorítmicos sobre el procedimiento de Gram–Schmidt.

Las reflexiones de Householder y las rotaciones de Givens proporcionan enfoques más numéricamente estables para este problema. Nótese que el desarrollo anterior no cambia en el caso general de la descomposición QR. Es decir, sea $$ \m X = \m Q \m R \>, $$ cualquier descomposición QR de $\m X$. Luego, usando exactamente el mismo razonamiento y manipulaciones algebraicas que arriba, tenemos que la solución de mínimos cuadrados $\bhat$ satisface $$ \m R^T \m R \bhat = \m R^T \m Q^T \m y \>, $$ lo cual se simplifica a $$ \m R \bhat = \m Q^T \m y \> . $$ Dado que $\m R$ es triangular superior, entonces la misma técnica de sustitución inversa funciona. Primero resolvemos para $\bhat_p$ y luego avanzamos desde abajo hacia arriba. La elección de cuál algoritmo de descomposición QR usar generalmente depende de controlar la inestabilidad numérica y, desde este punto de vista, Gram–Schmidt generalmente no es un enfoque competitivo.

Esta noción de descomponer $\m X$ como una matriz ortogonal por algo más se puede generalizar un poco más para obtener una forma muy general para el vector ajustado $\hat{\m y}$, pero temo que esta respuesta ya se haya vuelto demasiado larga.